1. 확률적 경사하강법(SGD)

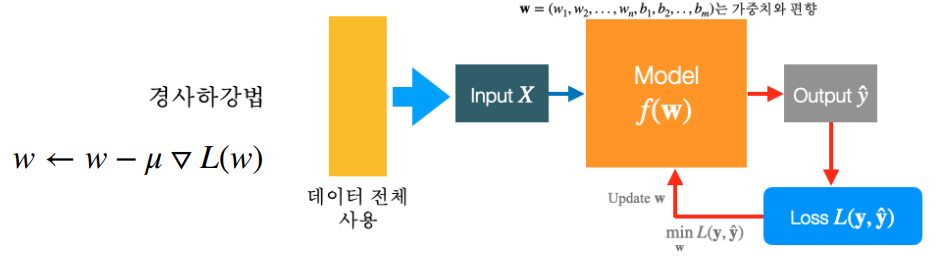

경사 하강법

- 경사하강법은 전체 데이터를 사용합니다. 그러나 데이터가 많으면 하드웨어적으로 메모리 부족으로 프로세스가 느려지고 실행되지 않을 수 있습니다.

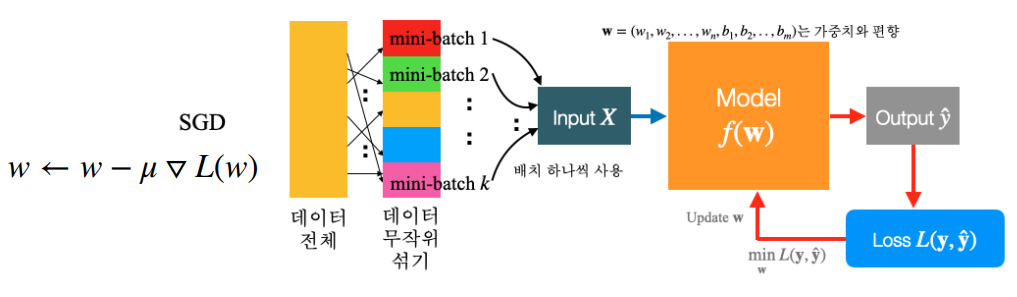

확률적 경사하강법

- 확률적 경사하강법은 데이터를 미니 배치로 분할합니다. 그 이후에는 주문이 영향을 받을 수 있습니다. 데이터를 섞은 후 미니 배치를 하나씩 추가합니다. 공식은 경사하강법과 동일합니다.

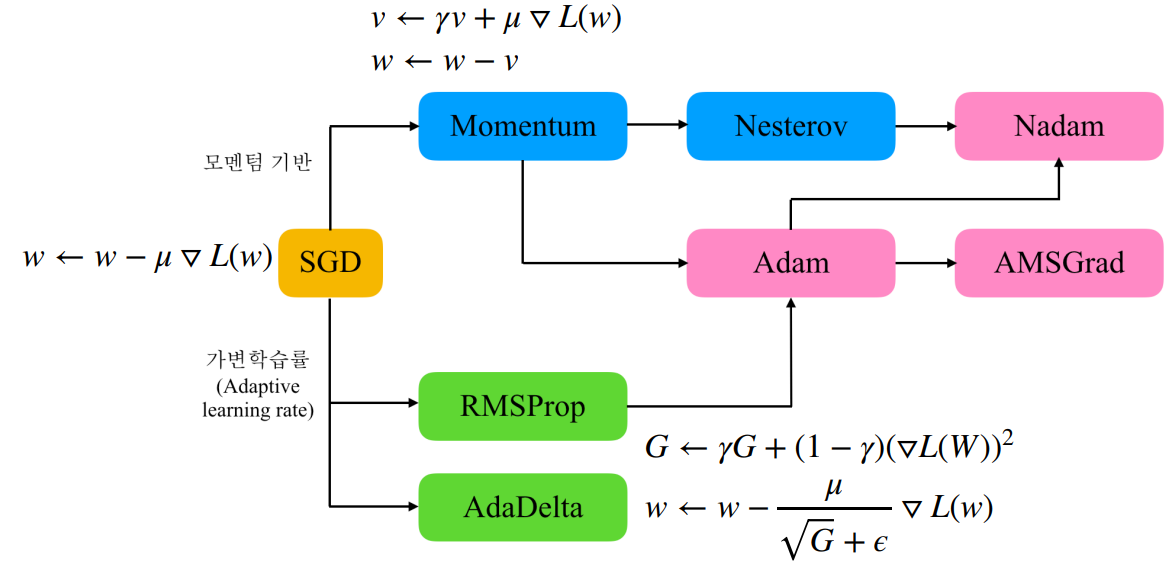

2. 여러 최적화 방법

- SGD의 증분은 고정된 값입니다. 이를 제어하는 두 가지 방법이 있습니다(업데이트할 수량).

1) 모멘텀 기반: 식 뒤에 추가 값이 추가됩니다. 현재 스텝 속도를 저장하고 다음 속도를 계산하여 값을 반환합니다(= 임펄스에 대한 표현). \( \gamma \) 값은 사용자가 설정하며 일반적으로 0.9입니다.

2) 적응적 학습률: 특정 규칙에 따라 \( \mu \)를 변경합니다.

- RMSProp: 기울기의 제곱 비율을 계속 누적합니다.

- 에이다델타

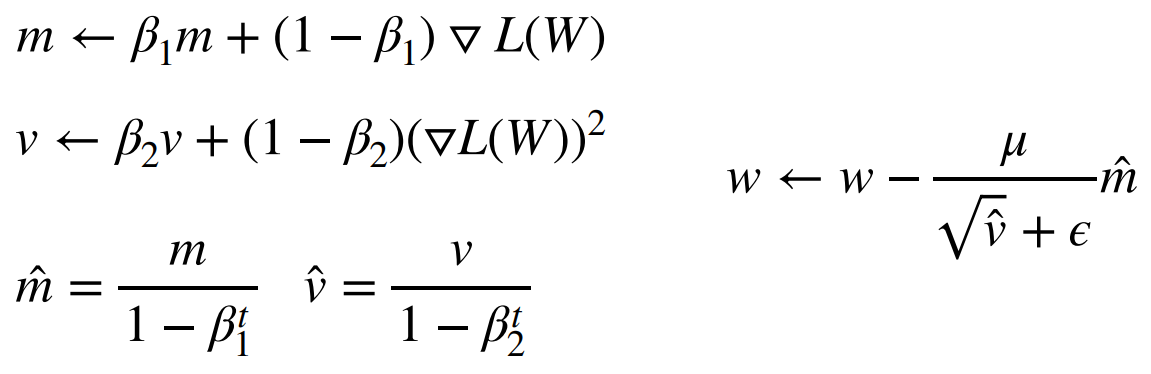

ADAM(적응 모멘트 추정)

- RMSProp 및 Momentum 개념 병합

- 가장 많이 사용

- 그라디언트 및 단계 크기 자체의 이전 정보를 저장하여 생성됩니다. \( \beta_{1} \) 및 \( \beta_{2} \)는 상수이며 사용자가 임의로 설정할 수 있습니다. \( \epsilon \)은 분모가 0이 되지 않도록 설정됩니다.

스케줄링

- 특정 시간에 대한 단계 크기 조정) – 학습 속도를 조정하자!

1) stepLR: 학습 과정의 수에 따른 계획. 증분이 작아진다

2) ExponentialLR: 단계 크기는 \( \gamma^{epoch}*\mu \)에 따라 점진적으로 감소합니다.

3) 코사인 글로우: 코사인 공식을 사용합니다. 반복적으로 setp 크기를 줄이고 늘립니다. Mu의 최소값과 최대값을 사용합니다.

평소 사용하는 그대로

- 싱가포르 달러 + 계획

- SGD + 모멘텀 + 기획